Solutions & Technology

SeiRen Real-time STT

음성을 실시간으로 텍스트로 변환합니다.

음성 인식 알고리즘을 활용하여 음성 데이터를 분석하고, 딥러닝을 통해 높은 정확도를 구현합니다.

InterRoid STT

Conformer-CTC는 Transformer와 CNN을 결합한 Conformer 모델을 기반으로, Connectionist Temporal Classification(CTC) 손실 함수를 사용하여 음성을 텍스트로 변환하는 STT(Speech-to-Text) 엔진입니다.

Conformer(Convolution-augmented Transformer)는 음성 인식에서 장거리 의존성(Long-range dependency) 학습과 지역적 특징(Local Feature) 학습을 동시에 처리할 수 있도록 설계되었습니다. CTC는 입력 길이와 출력 길이가 불일치하는 시퀀스 모델링 문제를 해결하며, 오디오 데이터에서 프레임 단위로 텍스트를 예측할 수 있도록 도와줍니다. 이를 통해 빠른 추론 속도와 정확한 인식 성능을 제공합니다.

Features

STT 엔진의 특징

Self-Attention + CNN 기반 Hybrid 모델

- Self-Attention: Transformer 기반 Self-Attention을 사용하여 장거리 의존성을 학습

- Convolution Module: CNN을 활용하여 지역적 특성을 인식하여 잡음 환경에서도 강인한 성능 유지

- CTC Alignment: 학습 시 CTC loss를 사용하여 정확한 음소 정렬

CTC Loss를 활용한 음성-텍스트 정렬

- CTC(Connectionist Temporal Classification) Loss는 음성의 프레임을 직접 텍스트와 정렬하는 방식

- 단어 단위 정렬이 필요 없는 End-to-End 방식으로 빠른 추론 가능

Streaming & Non-Streaming Hybrid 처리

- 실시간(Streaming) 및 비실시간(Non-streaming) 환경에서 유연하게 동작 가능

- Chunk-wise Attention을 통해 실시간 STT에도 활용 가능

Multi-head Self Attention(MHSA) + CNN Encoder

- 기존 Transformer 모델의 한계를 보완하여 연산량을 줄이고 성능을 향상

Sub-word Tokenization 및 Byte Pair Encoding(BPE)

- 사전 훈련된 BPE 모델을 활용하여 다양한 언어 환경에서 고품질 STT 구현 가능

- 문자 단위 예측보다 더 정밀한 텍스트 출력을 생성

Architecture

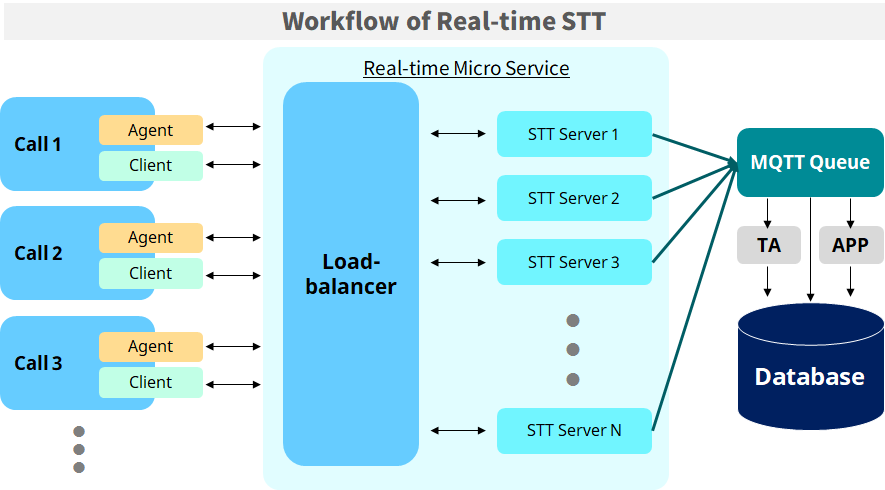

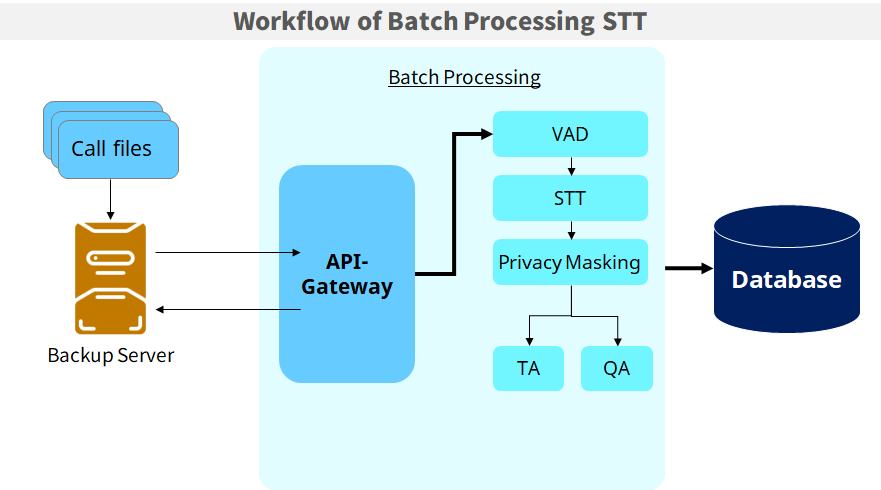

실시간 서비스 및 배치 처리 서비스 구현이 모두 가능합니다.

실시간(Real-time) 아키텍처

배치(Batch) 아키텍처

더 궁금한 점이 있으십니까?

더 필요한 정보가 있으시면 언제든지 연락주세요.